Articolo originale: The Docker Handbook – Learn Docker for Beginners

Il concetto di containerizzazione è piuttosto risalente, ma la nascita del Docker Engine nel 2013 ha reso molto più semplice la sua applicazione.

Secondo un sondaggio del 2020 di Stack Overflow, Docker è la 1ᵃ piattaforma più richiesta, la 2ᵃ piattaforma più amata e la 3ᵃ piattaforma più popolare.

Per quanto possa essere richiesta, i primi passi possono essere complicati. In questo manuale, impareremo tutto dalle basi della containerizzazione fino a un livello più intermedio. Dopo aver letto l'intero manuale, dovresti essere in grado di:

- Containerizzare (quasi) qualsiasi applicazione

- Caricare immagini Docker personalizzate su registri online

- Lavorare con container multipli usando Docker Compose

Prerequisiti

- Familiarità con il terminale Linux

- Familiarità con JavaScript (alcuni progetti richiedono l'uso di JavaScript)

Sommario

- Introduzione alla containerizzazione e a Docker

- Come installare Docker

- Hello World in Docker - Introduzione a Docker

- Le basi della manipolazione dei container in Docker

- Come eseguire un container

- Come pubblicare una porta

- Come usare l'opzione detach

- Come elencare i container

- Come dare un nome a un container o rinominarlo

- Come fermare un container in esecuzione

- Come riavviare un container

- Come creare un container senza eseguirlo

- Come rimuovere dei container sospesi

- Come eseguire un container in modalità interattiva

- Come eseguire comandi all'interno di un container

- Come lavorare con immagini eseguibili

- Manipolazione base delle immagini Docker

- Come creare un'immagine Docker

- Come taggare le immagini Docker

- Come elencare e rimuovere immagini Docker

- Come comprendere i livelli di un'immagine Docker

- Come eseguire il build di NGINX dalla sorgente

- Come ottimizzare le immagini Docker

- Alpine Linux

- Come creare immagini Docker eseguibili

- Come condividere le tue immagini Docker online

- Come containerizzare una app JavaScript

- Manipolazione base delle reti in Docker

- Come containerizzare un'applicazione JavaScript multi-container

- Come eseguire il server del database

- Come lavorare con i volumi in Docker

- Come accedere ai log da un container in Docker

- Come creare una rete e collegare il server del database in Docker

- Come scrivere il Dockerfile

- Come eseguire i comandi in un container in esecuzione

- Come scrivere degli script di gestione in Docker

- Come comporre i progetti usando Docker Compose

- Le basi di Docker Compose

- Come avviare i servizi in Docker Compose

- Come elencare i servizi in Docker Compose

- Come eseguire dei comandi all'interno di un servizio in esecuzione in Docker Compose

- Come accedere ai log da un servizio in esecuzione in Docker Compose

- Come fermare dei servizi in Docker Compose

- Come comporre un'applicazione full-stack in Docker Compose

- Conclusione

Il codice dei progetti

Il codice dei progetti di esempio è disponibile nel seguente repository:

Puoi trovare il codice completo nel branch completed.

Contributi

Questo libro è completamente open-source e le contribuzioni di qualità sono ben accette. Puoi trovare il contenuto integrale nel seguente repository:

Di solito, apporto le modifiche prima alla versione GitBook del manuale e poi la pubblico su freeCodeCamp. Puoi trovare la versione sempre aggiornata e spesso instabile del libro al seguente link:

Se desideri una versione statica ma stabile, freeCodeCamp è miglior posto dove trovarla:

Qualsiasi versione finirai per leggere, non dimenticarmi di dirmi cosa ne pensi. Le critiche costruttive sono sempre ben accette.

Introduzione alla containerizzazione e a Docker

Secondo IBM,

La containerizzazione implica l'incapsulamento o l'impacchettamento del codice di un software e di tutte le sue dipendenze, in modo che possa essere eseguito in modo uniforme e coerente su qualsiasi infrastruttura.

In altre parole, la containerizzazione ti consente di impacchettare un software con tutte le sue dipendenze in un pacchetto autonomo, così da poterlo eseguire senza passare per un fastidioso processo di configurazione.

Consideriamo un caso pratico. Immagina di aver sviluppato una fantastica applicazione per la gestione di libri, che può contenere informazioni su tutti i libri che possiedi e può anche servire come sistema di prestito per i tuoi amici.

Se fai una lista delle dipendenze, dovrebbe essere qualcosa del genere:

- Node.js

- Express.js

- SQLite3

Bene, teoricamente dovrebbe essere tutto. Ma in pratica ci sono anche altre cose. Viene fuori che Node.js usa uno strumento di build chiamato node-gyp per il build degli add-on. E secondo le istruzioni di installazione nel repository ufficiale, questo strumento di build richiede Python 2 o 3 e una appropriata tool-chain per il compilatore C/C++.

Considerando tutto ciò, la lista finale delle dipendenze è la seguente:

- Node.js

- Express.js

- SQLite3

- Python 2 o 3

- C/C++ tool-chain

Installare Python 2 o 3 è piuttosto semplice indipendentemente dalla piattaforma, mentre configurare la tool-chain di C/C++ è abbastanza facile su Linux, ma su Windows e Mac è un'attività piuttosto spiacevole.

Su Windows, il pacchetto degli strumenti di build di C/C++ è nell'ordine dei gigabyte e richiede del tempo per essere installato. Su un Mac, puoi installare l'enorme applicazione Xcode oppure il pacchetto più piccolo di strumenti per la riga di comando per Xcode.

Indipendentemente da ciò che installi, potrebbero esserci comunque problemi con gli aggiornamenti del sistema operativo. È così comune che ci sono delle note d'installazione per macOS Catalina disponibili sul repository ufficiale.

Ipotizziamo che hai superato tutte queste noie, configurando tutte le dipendenze e hai iniziato a lavorare sul progetto. Significa che sei fuori pericolo? Naturalmente no.

E se un tuo collega utilizza Windows mentre tu usi Linux? Adesso devi considerare tutte le incongruenze relative a come i due sistemi operativi gestiscono i percorsi. Oppure il fatto che tecnologie popolari come nginx non sono ottimizzate per Windows. Alcune tecnologie come Redis non sono neanche pre-configurate per Windows.

Anche se dovessi affrontare l'intera fase di sviluppo, cosa accade se la persona responsabile della gestione dei server esegue una procedura di deployment errata?

Tutti questi problemi possono essere risolti se soltanto potessi:

- Sviluppare ed eseguire l'applicazione all'interno di un ambiente isolato (detto container) che corrisponde all'ambiente finale di distribuzione.

- Mettere l'applicazione all'interno di un singolo file (detto immagine) insieme a tutte le sue dipendenze e le configurazioni necessarie per il deployment.

- E condividere l'immagine a un server centrale (detto registro), accessibile da chiunque abbia l'autorizzazione appropriata.

I tuoi colleghi saranno in grado di scaricare l'immagine dal registro, eseguire l'applicazione, dato che è all'interno di un ambiente isolato e libero dalle incongruenze dovute a una specifica piattaforma, o anche distribuire direttamente da un server, visto che l'immagine è provvista di tutte le configurazioni di produzione appropriate.

Questa è l'idea alla base della containerizzazione: inserire un'applicazione all'interno di un pacchetto autonomo, renderla portabile e riproducibile in diversi ambienti.

E adesso la domande è "che ruolo svolge Docker?".

Come già menzionato, la containerizzazione è un'idea che risolve una miriade di problemi nello sviluppo di software inserendo le cose in una scatola.

Questa idea può essere messa in atto in vari modi. Docker è uno di questi. È una piattaforma open-source di containerizzazione che ti consente di containerizzare le tue applicazioni, condividerle usando dei registri pubblici o privati, e anche di orchestrarle.

Docker non è l'unico strumento di containerizzazione sul mercato, è soltanto il più conosciuto. Un altro motore di containerizzazione che amo si chiama Podman, sviluppato da Red Hat. Altri strumenti come Kaniko di Google, rkt di CoreOS sono fantastici, eppure non sono ancora pronti rimpiazzare Docker.

Se vuoi una lezione di storia, potresti leggere A Brief History of Containers: From the 1970s Till Now (risorsa in inglese) che parla dei momenti decisivi di questa tecnologia.

Come installare Docker

L'installazione di Docker varia largamente a seconda del sistema operativo in uso. Ma è comunque generalmente semplice.

Docker gira alla perfezione su tutte e tre le piattaforme principali, Mac, Windows e Linux. Tra le tre, il processo di installazione su Mac è più semplice, quindi partiremo da qui.

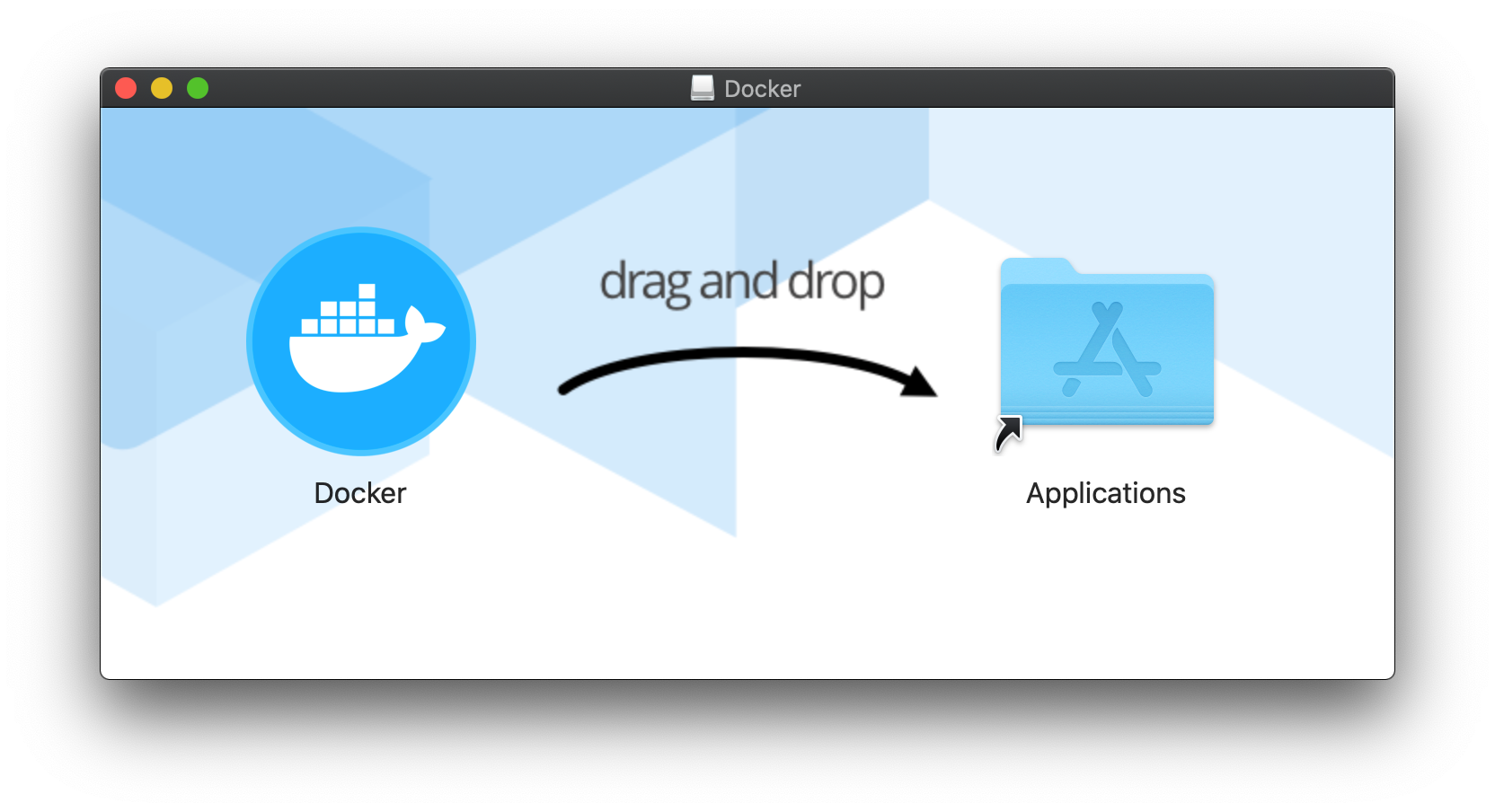

Come installare Docker su macOS

Su un mac, tutto ciò che devi fare è andare sulla pagina ufficiale di download e cliccare il pulsante Download for Mac (stable).

Otterrai un file Apple Disk Image dall'aspetto normale e al suo interno ci sarà l'applicazione. Tutto ciò che devi fare è trascinare il file e rilasciarlo nella cartella Applicazioni.

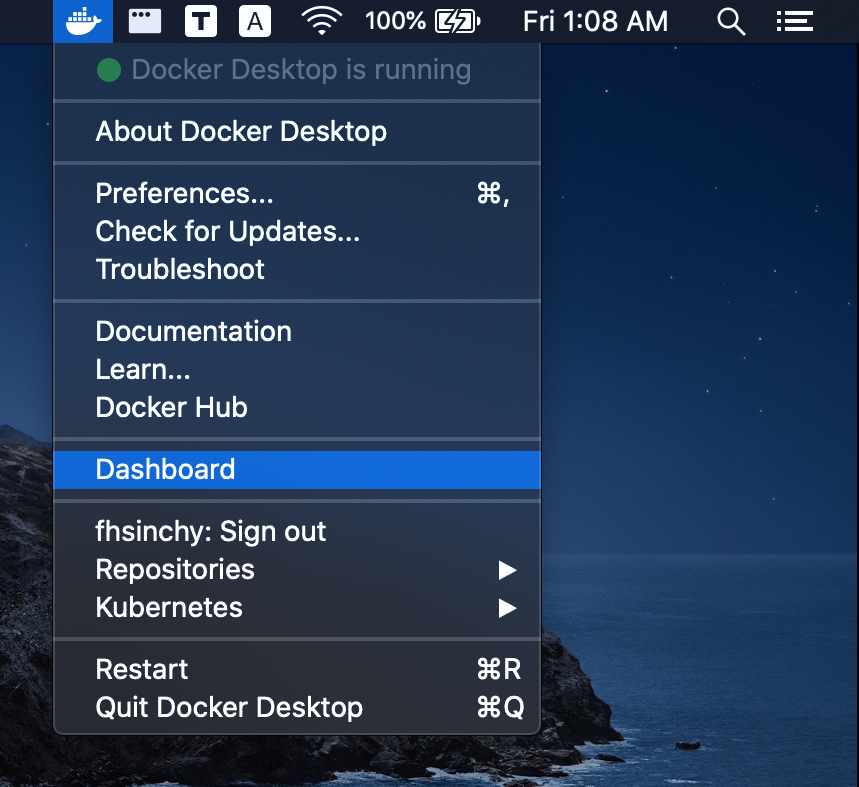

Puoi avviare Docker facendo semplicemente doppio click sull'icona dell'applicazione. Una volta che l'applicazione si avvia, vedrai l'icona di Docker apparire nella barra del menu.

Adesso, apri il terminale ed esegui docker --version e docker-compose --version per assicurarti che l'installazione sia andata a buon fine.

Come installare Docker su Windows

Su Windows, la procedura è quasi la stessa, eccetto che ci sono alcuni passaggi aggiuntivi da svolgere. I passaggi per l'installazione sono i seguenti:

- Vai su questo sito e segui le istruzioni per installare WSL2 su Windows 10.

- Vai sulla pagina ufficiale di download e clicca sul pulsante Download for Windows (stable).

- Fai doppio click sull'installer scaricato e segui l'installazione predefinita.

Una volta terminata, avvia Docker Desktop dal menu start o dal desktop. L'icona di Docker apparirà nella barra delle applicazioni.

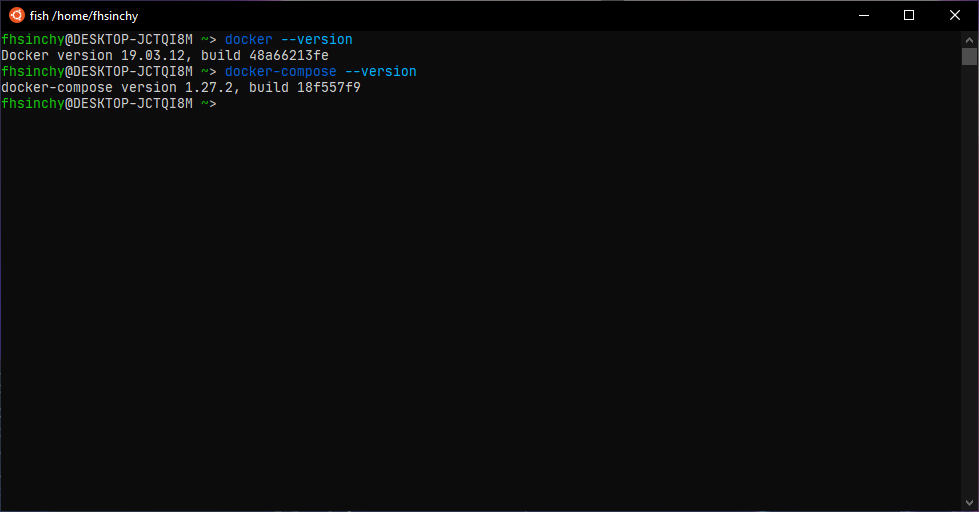

Apri Ubuntu o qualsiasi distribuzione hai installato dal Microsoft Store. Esegui i comandi docker --version e docker-compose --version per assicurarti che l'installazione abbia avuto successo.

Puoi accedere a Docker anche dal prompt dei comandi o da PowerShell. È solo che preferisco utilizzare WSL2 rispetto ad altre righe di comando su Windows.

Come installare Docker su Linux

L'installazione di Docker su Linux è un processo leggermente diverso e, in base alla distribuzione, può cambiare ancora di più. Ma, onestamente, l'installazione è comunque semplice come sulle altre due piattaforme (se non di più).

Il pacchetto Docker Desktop su Windows o Mac è un insieme di strumenti come Docker Engine, Docker Compose, Docker Dashboard, Kubernetes e qualche altra chicca.

Su Linux invece, non avrai questa collezione, ma dovrai installare manualmente tutti gli strumenti necessari. Le procedure di installazione per le diverse distribuzioni sono le seguenti:

- Se sei su Ubuntu, puoi seguire la sezione Install Docker Engine on Ubuntu della documentazione ufficiale.

- Per le altre distribuzioni, sono disponibili guide nella documentazione ufficiale.

- Install Docker Engine on Debian

- Install Docker Engine on Fedora

- Install Docker Engine on CentOS

- Se sei su una distribuzione non elencata nella documentazione, puoi seguire la guida Install Docker Engine from binaries.

- Indipendentemente dalla procedura che segui, dovrai svolgere degli importanti passaggi post-installazione per Linux.

- Una volta terminata l'installazione, dovrai installare un altro strumento chiamato Docker Compose. Puoi seguire la guida Install Docker Compose dalla documentazione ufficiale.

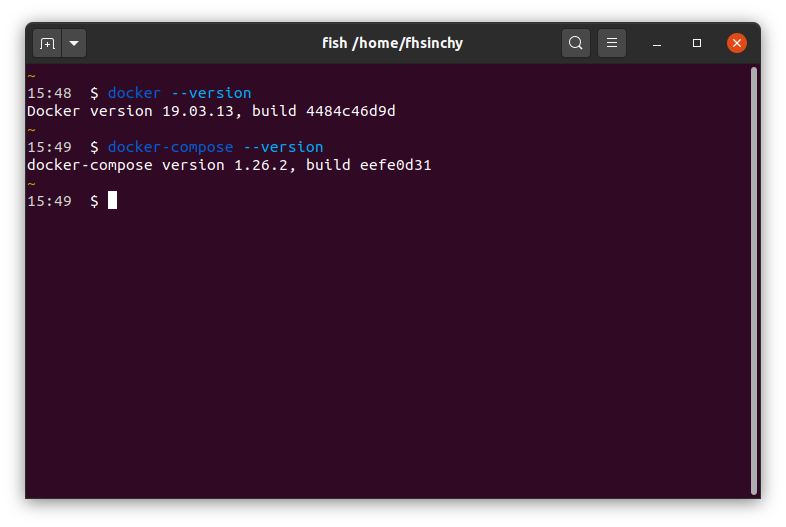

Quando hai concluso l'installazione, apri il terminale ed esegui docker --version e docker-compose --version per assicurarti che l'installazione sia avvenuta con successo.

Sebbene le prestazioni di Docker siano piuttosto buone indipendentemente dalla piattaforma, preferisco Linux rispetto alle altre. In tutto il manuale, mi alternerò tra le mie postazioni Ubuntu 20.10 e Fedora 33.

Un'altra cosa che vorrei chiarire fin dall'inizio è che non utilizzerò nessuno strumento GUI per lavorare con Docker in questo manuale.

Sono consapevole che ci sono disponibili dei validi strumenti GUI per varie piattaforme, ma imparare i comandi docker comuni è uno degli obiettivi primari di questo libro.

Hello World in Docker – Introduzione a Docker

Ora che hai Docker sulla tua macchina, è tempo per eseguire il tuo primo container. Apri il terminale ed esegui il seguente comando:

docker run hello-world

# Unable to find image 'hello-world:latest' locally

# latest: Pulling from library/hello-world

# 0e03bdcc26d7: Pull complete

# Digest: sha256:4cf9c47f86df71d48364001ede3a4fcd85ae80ce02ebad74156906caff5378bc

# Status: Downloaded newer image for hello-world:latest

#

# Hello from Docker!

# This message shows that your installation appears to be working correctly.

#

# To generate this message, Docker took the following steps:

# 1. The Docker client contacted the Docker daemon.

# 2. The Docker daemon pulled the "hello-world" image from the Docker Hub.

# (amd64)

# 3. The Docker daemon created a new container from that image which runs the

# executable that produces the output you are currently reading.

# 4. The Docker daemon streamed that output to the Docker client, which sent it

# to your terminal.

#

# To try something more ambitious, you can run an Ubuntu container with:

# $ docker run -it ubuntu bash

#

# Share images, automate workflows, and more with a free Docker ID:

# https://hub.docker.com/

#

# For more examples and ideas, visit:

# https://docs.docker.com/get-started/

L'immagine hello-world è un esempio minimale di containerizzazione con Docker. Contiene un singolo programma compilato da un file hello.c, responsabile di stampare sul terminale il messaggio che stai vedendo.

Nel terminale, puoi usare il comando docker ps -a per dare un'occhiata a tutti i container attualmente in esecuzione o eseguiti in passato:

docker ps -a

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# 128ec8ceab71 hello-world "/hello" 14 seconds ago Exited (0) 13 seconds ago exciting_chebyshevNell'output, un container chiamato exciting_chebyshev è stato eseguito con il container id 128ec8ceab71 usando l'immagine hello-world. In Exited (0) 13 seconds ago, il codice di uscita (0) sta a indicare che non sono stati prodotti errori durante il runtime del container.

Per capire cosa è accaduto dietro le quinte, dovrai acquisire familiarità con l'architettura di Docker e tre dei concetti fondamentali della containerizzazione in generale, che sono:

- Container

- Immagine

- Registro

Li ho elencati in ordine alfabetico e inizierò le mie spiegazioni dal primo della lista.

Cos'è un container?

Nella parola containerizzazione non può esserci nulla di più fondamentale del concetto di container.

Il sito delle risorse ufficiali di Docker afferma che:

Un contenitore è un'astrazione al livello dell'applicazione che impacchetta insieme il codice e le dipendenze. Invece di virtualizzare l'intera macchina fisica, i container virtualizzano solo il sistema operativo host.

Puoi considerare i container come la prossima generazione di macchine virtuali.

Proprio come le macchine virtuali, i container sono ambienti completamente isolati dal sistema che li ospita, così come tra di loro. Sono anche molto più leggeri rispetto alle macchine virtuali tradizionali, quindi un gran numero di container può essere eseguito simultaneamente senza influenzare le prestazioni del sistema che li ospita.

I container e le macchine virtuali, in realtà, sono dei modi differenti di virtualizzare l'hardware fisico. La differenza principale tra i due è il metodo di virtualizzazione.

Le macchine virtuali sono solitamente create e gestite da un programma detto hypervisor (o ipervisore), come Oracle VM VirtualBox, VMware Workstation, KVM, Microsoft Hyper-V e via dicendo. Il programma hypervisor di solito è posto tra il sistema operativo e le macchina virtuale e agisce come mezzo di comunicazione.

Ogni macchina virtuale possiede il suo sistema operativo guest, che è pesante tanto quanto un sistema operativo host.

L'applicazione all'interno di una macchina virtuale comunica con il sistema operativo guest, che parla con l'hypervisor, che a sua volta comunica con il sistema operativo host per allocare le risorse necessarie dall'infrastruttura fisica per eseguire l'applicazione.

Come puoi vedere, si tratta di una lunga catena di comunicazione tra le applicazioni in esecuzione all'interno della macchina virtuale e le infrastrutture fisiche. Le applicazioni in esecuzione all'interno della macchina virtuale potrebbero richiedere solo una piccola quantità di risorse, ma il sistema operativo guest aggiunge un notevole carico.

A differenza di una macchina virtuale, un container svolge il lavoro di virtualizzazione in un modo più intelligente. Invece di avere un sistema operativo guest completo all'interno del contenitore, utilizza il sistema operativo host attraverso il runtime del container, mantenendo al contempo l'isolamento – come una macchina virtuale tradizionale.

Il runtime del container, ovvero Docker, si trova tra il container e il sistema operativo host al posto dell'hypervisor. I container comunicano con il runtime del container, che poi comunica con il sistema operativo host per ottenere le risorse necessarie dall'infrastruttura fisica.

Come risultato dell'eliminazione dell'intero livello del sistema operativo guest, i container sono molto più leggeri e meno avidi di risorse rispetto alle tradizionali macchine virtuali.

Come dimostrazione di questo punto, guarda il seguente blocco di codice:

uname -a

# Linux alpha-centauri 5.8.0-22-generic #23-Ubuntu SMP Fri Oct 9 00:34:40 UTC 2020 x86_64 x86_64 x86_64 GNU/Linux

docker run alpine uname -a

# Linux f08dbbe9199b 5.8.0-22-generic #23-Ubuntu SMP Fri Oct 9 00:34:40 UTC 2020 x86_64 LinuxNel blocco di codice qui sopra, ho eseguito il comando uname -a sul mio sistema operativo host per stampare i dettagli sul kernel. Poi, nella riga successiva, ho eseguito lo stesso comando all'interno del container di Alpine Linux.

Come puoi vedere nell'output, il container sta effettivamente usando il kernel del sistema operativo host. Questo prova che i container virtualizzano il sistema operativo host invece di avere un proprio sistema operativo.

Se sei su una macchina Windows, scoprirai che tutti i container usano il kernel WSL2. Questo accade perché WSL2 agisce come back-end per Docker su Windows. Su macOS il back-end predefinito è una macchina virtuale con un hypervisor HyperKit.

Cos'è un'immagine Docker?

Le immagini sono dei file autonomi a più livelli che agiscono come modello per la creazione di container. Sono come una copia congelata, di sola lettura di un container. Le immagini possono essere scambiate attraverso dei registri.

Nel passato, diversi motori di container avevano formati immagine diversi. Successivamente, L'OCI (Open Container Initiative) ha definito delle specifiche standard per le immagini di container a cui aderiscono i principali motori di containerizzazione. Ciò significa che un'immagine creata con Docker può essere usata con un altro runtime come Podman senza altre seccature.

I container sono semplicemente immagini nello stato di esecuzione. Quando ottieni un'immagine da internet ed esegui un container usando un'immagine, crei essenzialmente un altro livello scrivibile temporaneo sopra a quelli di sola lettura.

Questo concetto diventerà molto più chiaro nelle prossime sezioni di questo libro, ma per ora tieni a mente che le immagini sono file a più livelli e di sola lettura che portano un'applicazione nello stato desiderato al loro interno.

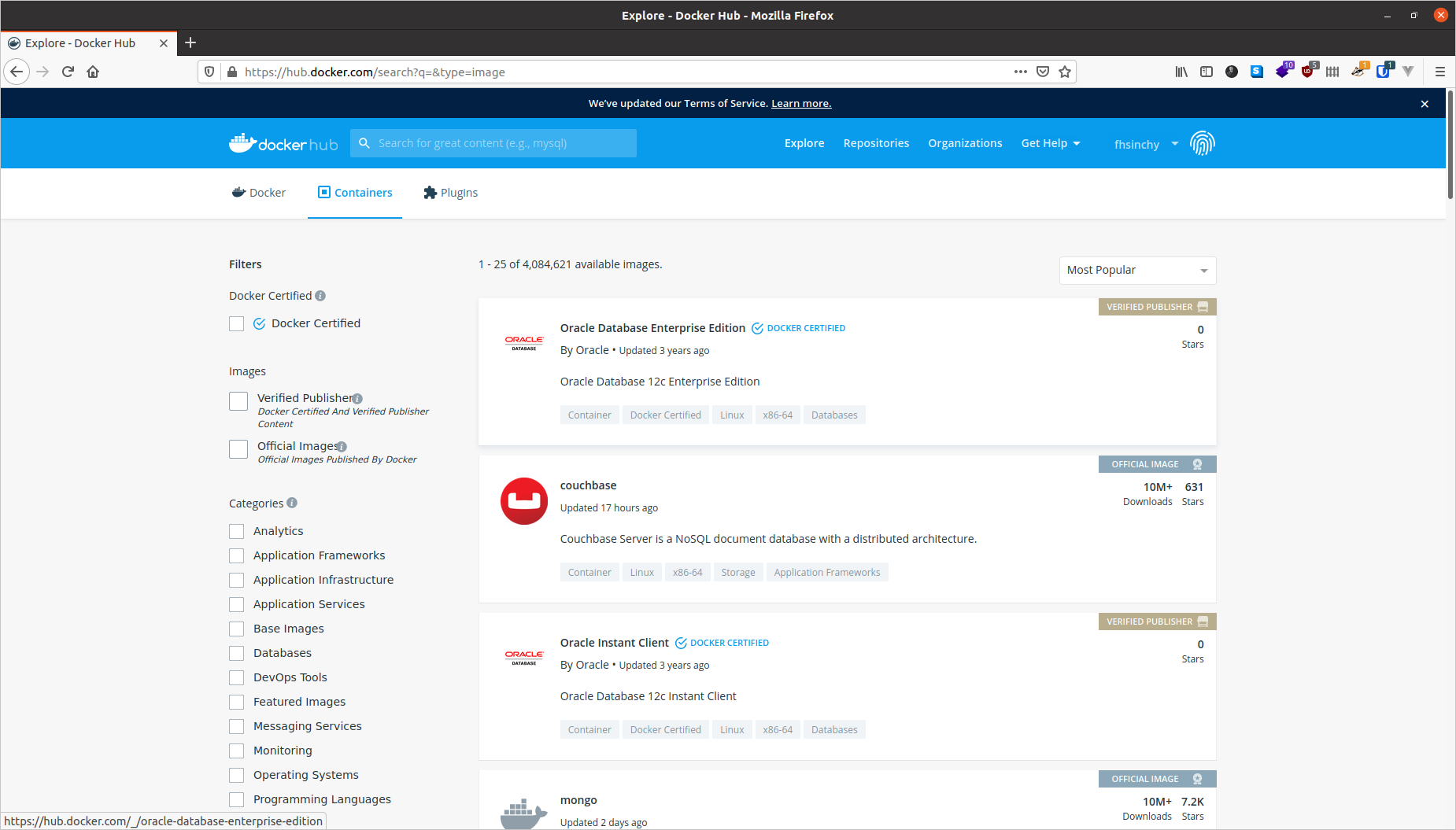

Cos'è un registro Docker?

Hai già imparato cosa sono due importanti pezzi del puzzle, i container e le immagini. Il pezzo finale è il registro.

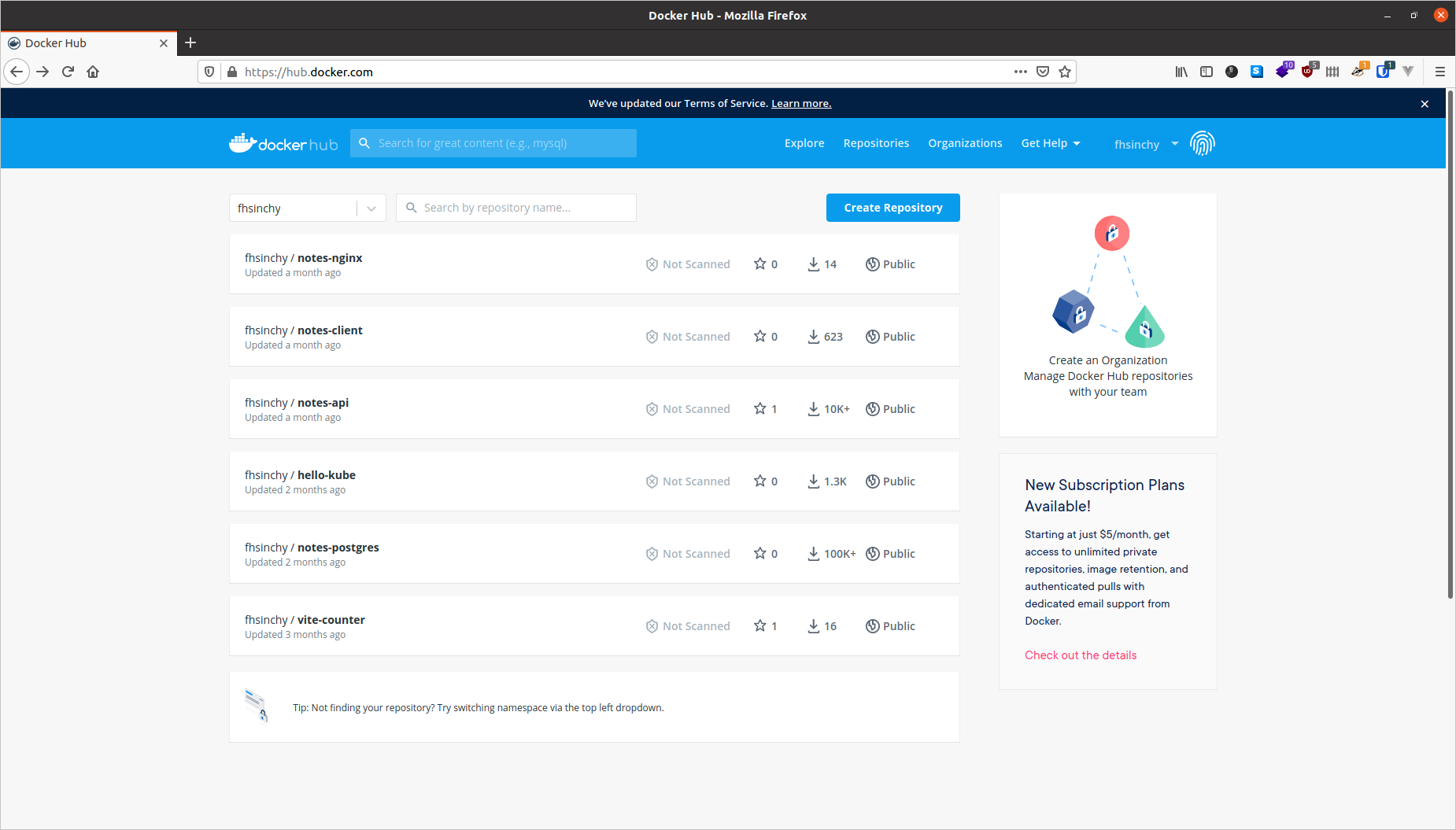

Un registro di immagini è un luogo centralizzato in cui puoi caricare le tue immagini e scaricare le immagini create da altri. Docker Hub è il registro pubblico predefinito per Docker. Un altro registro di immagini molto popolare è Quay di Red Hat.

In questo manuale ho scelto di utilizzare Docker Hub come registro.

Puoi condividere gratuitamente un qualsiasi numero di immagini pubbliche su Docker Hub. Le persone in tutto il modo saranno in grado di scaricarle e usarle liberamente. Le immagini che ho caricato sono disponibili sulla pagina del mio profilo (fhsinchy).

Oltre a Docker Hub o Quay, puoi anche creare il tuo registro di immagini in cui ospitare immagini private. Esiste anche un registro locale in esecuzione sul tuo computer che memorizza nella cache le immagini scaricate dai registri remoti.

Una panoramica dell'architettura Docker

Ora che hai un'idea dei concetti fondamentali della containerizzazione e di Docker, è tempo di capire come è stato progettato Docker come software.

Il motore consiste di tre componenti principali:

- Docker Daemon: il demone (

dockerd) è un processo che continua a essere eseguito in background e attende i comandi dal client. Il demone è in grado di gestire vari oggetti Docker. - Docker Client: Il client (

docker) è un'interfaccia da riga di comando principalmente responsabile del trasporto dei comandi lanciati dagli utenti. - REST API: l'API REST agisce come un ponte tra il demone e il client. Ogni comando lanciato usando il client passa per l'API per raggiungere il demone alla fine.

Secondo la documentazione ufficiale:

"Docker utilizza un'architettura client-server. Il client di Docker comunica con il demone, che svolge il lavoro sporco di fare il build, eseguire e distribuire i container Docker".

Come utente, eseguirai i comandi usando il componente client, il quale userà l'API REST per comunicare con il demone in esecuzione prolungata e svolgere il lavoro.

Il quadro completo

Ok, basta chiacchiere. È il momento di capire come lavorano in armonia tutti i pezzi del puzzle che hai appena conosciuto. Prima di tuffarci nelle spiegazioni di ciò che accade realmente quando esegui il comando docker run hello-world, ecco un piccolo diagramma che ho creato:

Questa immagine è una versione leggermente modificata di quella presente nella documentazione ufficiale. Gli eventi che si verificano quando esegui il comando sono i seguenti:

- Esegui il comando

docker run hello-worlddovehello-worldè il nome dell'immagine. - Il client di Docker comunica con il demone, dicendogli di prendere l'immagine

hello-worlded eseguire un container per questa immagine. - Docker daemon cerca l'immagine nel tuo repository locale e si rende conto che non c'è, restituendo

Unable to find image 'hello-world:latest' locallystampato sul terminale. - Il demone poi comunica con il registro pubblico, Docker Hub, e scarica l'ultima copia dell'immagine

hello-world, indicata dalla rigalatest: Pulling from library/hello-worldnel terminale. - Docker daemon poi crea un nuovo container dall'immagine appena scaricata.

- Infine Docker daemon esegue il container creato usando l'immagine

hello-worldgenerando come output il muro di testo sul tuo terminale.

Cercare nell'hub le immagini non presenti localmente è il comportamento predefinito di Docker. Ma una volta che l'immagine è stata recuperata, starà nella cache locale. Quindi, se esegui ancora il comando, non vedrai le seguenti righe di output:

Unable to find image 'hello-world:latest' locally

latest: Pulling from library/hello-world

0e03bdcc26d7: Pull complete

Digest: sha256:d58e752213a51785838f9eed2b7a498ffa1cb3aa7f946dda11af39286c3db9a9

Status: Downloaded newer image for hello-world:latestSe c'è una nuova versione dell'immagine disponibile nel registro pubblico, il demone recupererà di nuovo l'immagine. :latest è un tag. Le immagini hanno solitamente dei tag significativi per indicare le versioni o i build. Ne riparleremo in dettaglio più avanti.

Le basi della manipolazione dei container in Docker

Nelle sezioni precedenti, hai imparato gli elementi costitutivi di Docker e hai anche eseguito un container usando il comando docker run.

In questa sezione, apprenderai come manipolare i container nel dettaglio. La manipolazione dei container è l'attività più comune che ti troverai a svolgere quotidianamente, quindi capire bene i vari comandi è cruciale.

Tieni a mente che questo non è un elenco esaustivo di tutti i comandi che puoi eseguire su Docker. Riporterò solo quelli più comuni. In qualsiasi momento tu voglia imparare di più sui comandi disponibili, visita i riferimenti ufficiali per la riga di comando Docker.

Come eseguire un container

Precedentemente hai usato docker run per creare e avviare un container usando l'immagine hello-world. La sintassi generica di questo comando è la seguente:

docker run <nome immagine>Sebbene questo sia un comando perfettamente valido, c'è un modo migliore di inviare comandi al demone.

Prima della versione 1.13, Docker aveva soltanto la sintassi precedentemente menzionata per quel comando. Successivamente, la riga di comando è stata ristrutturata per avere la seguente sintassi:

docker <oggetto> <comando> <opzioni>In questa sintassi:

oggettoindica il tipo di oggetto Docker da manipolare. Può essere un oggettocontainer,image,networkovolume.comandoindica l'azione che deve essere svolta dal demone, cioè il comandorun.opzionipuò essere qualsiasi parametro valido che può sovrascrivere il comportamento predefinito del comando, come l'opzione--publishper il port mapping.

Seguendo questa sintassi, il comando run può essere scritto come segue:

docker container run <nome immagine>nome immagine può appartenere a qualsiasi immagine da un registro online o sul tuo sistema locale. Come esempio, puoi provare a eseguire il container usando l'immagine fhsinchy/hello-dock. Questa immagine contiene una semplice applicazione Vue.js che viene eseguita sulla porta 80 all'interno del container.

Per eseguire un container usando questa immagine, esegui il seguente comando sul terminale:

docker container run --publish 8080:80 fhsinchy/hello-dock

# /docker-entrypoint.sh: /docker-entrypoint.d/ is not empty, will attempt to perform configuration

# /docker-entrypoint.sh: Looking for shell scripts in /docker-entrypoint.d/

# /docker-entrypoint.sh: Launching /docker-entrypoint.d/10-listen-on-ipv6-by-default.sh

# 10-listen-on-ipv6-by-default.sh: Getting the checksum of /etc/nginx/conf.d/default.conf

# 10-listen-on-ipv6-by-default.sh: Enabled listen on IPv6 in /etc/nginx/conf.d/default.conf

# /docker-entrypoint.sh: Launching /docker-entrypoint.d/20-envsubst-on-templates.sh

# /docker-entrypoint.sh: Configuration complete; ready for start upIl comando è piuttosto esplicito. L'unica porzione che potrebbe richiedere qualche spiegazione è --publish 8080:80, di cui parleremo nella prossima sezione.

Come pubblicare una porta

I container sono ambienti isolati. Il tuo sistema host non sa nulla di ciò che accade in un container. Dunque le applicazioni all'interno di un container restano inaccessibili dall'esterno.

Per consentire l'accesso dall'esterno di un container, devi pubblicare la porta appropriata all'interno del container su una porta sulla tua rete locale. La sintassi comune per l'opzione --publish o -p è la seguente:

--publish <porta host>:<porta container>--publish 8080:80 nella sezione precedente, vuol dire che ogni richiesta inviata alla porta 8080 del sistema host viene inoltrata alla porta 80 all'interno del container.

Per accedere all'applicazione sul browser, visita http://127.0.0.1:8080.

Puoi stoppare il container semplicemente premendo la combinazione di tasti ctrl + c mentre la finestra del terminale è in focus, oppure chiudere completamente la finestra del terminale.

Come usare l'opzione detach

Un'altra opzione molto popolare del comando run è --detach o -d. Nell'esempio precedente, per mantenere il container in esecuzione hai tenuto aperta la finestra del terminale. Chiudere la finestra del terminale avrebbe interrotto l'esecuzione del container.

Questo perché, per impostazione predefinita, i container vengono eseguiti in primo piano e si collegano al terminale come qualsiasi altro normale programma invocato del terminale.

Per sovrascrivere questo comportamento e mantenere il container in esecuzione in background, puoi includere l'opzione --detach con il comando run come segue:

docker container run --detach --publish 8080:80 fhsinchy/hello-dock

# 9f21cb77705810797c4b847dbd330d9c732ffddba14fb435470567a7a3f46cdcA differenza dell'esempio precedente, stavolta non otterrai un muro di testo. Invece, otterrai l'ID del container appena creato.

L'ordine delle opzioni che fornisci non è davvero importante. Se metti l'opzione --publish prima dell'opzione --detach, funziona allo stesso modo. Una cosa da tenere a mente per il comando run è che il nome dell'immagine deve essere inserito per ultimo. Se aggiungi qualsiasi cosa dopo il nome dell'immagine, sarà passato come argomento all'entry-point del container (vedi sezione Come eseguire comandi all'interno di un container) e potrebbe creare situazioni inaspettate.

Come elencare i container

Il comando container ls può essere usato per elencare i container attualmente in esecuzione:

docker container ls

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# 9f21cb777058 fhsinchy/hello-dock "/docker-entrypoint.…" 5 seconds ago Up 5 seconds 0.0.0.0:8080->80/tcp gifted_sammetUn container chiamato gifted_sammet è in esecuzione. È stato creato 5 secondi fa (5 seconds ago) e lo status è Up 5 seconds, che indica che il container è stato correttamente in esecuzione dal momento della sua creazione.

CONTAINER ID è 9f21cb777058, i primi 12 caratteri dell'ID completo del container. L'ID completo è 9f21cb77705810797c4b847dbd330d9c732ffddba14fb435470567a7a3f46cdc, che è lungo 64 caratteri ed è stato stampato come output del comando docker container run nella sezione precedente.

La porta 8080 della tua rete locale, elencata nella colonna PORTS, sta puntando alla porta 80 all'interno del container. Il nome gifted_sammet è generato da Docker e può essere completamente diverso nel tuo computer.

Il comando container ls elenca solo i container attualmente in esecuzione sul tuo sistema. Per elencare tutti i container eseguiti in passato puoi usare l'opzione --all o -a.

docker container ls --all

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# 9f21cb777058 fhsinchy/hello-dock "/docker-entrypoint.…" 2 minutes ago Up 2 minutes 0.0.0.0:8080->80/tcp gifted_sammet

# 6cf52771dde1 fhsinchy/hello-dock "/docker-entrypoint.…" 3 minutes ago Exited (0) 3 minutes ago reverent_torvalds

# 128ec8ceab71 hello-world "/hello" 4 minutes ago Exited (0) 4 minutes ago exciting_chebyshevCome puoi vedere il secondo container nella lista, reverent_torvalds, è stato creato prima e ha il codice di stato 0, che indica che non è stato prodotto nessun errore durante il runtime del container.

Come dare un nome a un container o rinominarlo

Di default, ogni container ha due identificatori:

- ID - una stringa composta da un numero casuale di 64 caratteri.

- Nome - una combinazione di due parole casuali unite da un trattino basso.

Fare riferimento a un container sulla base di due identificatori casuali è piuttosto sconveniente. Sarebbe ottimale poter riferirsi ai container usando un nome definito da te.

È possibile dare un nome a un container usando l'opzione --name. Per eseguire un altro container usando l'immagine fhsinchy/hello-dock con il nome hello-dock-container puoi eseguire il seguente comando:

docker container run --detach --publish 8888:80 --name hello-dock-container fhsinchy/hello-dock

# b1db06e400c4c5e81a93a64d30acc1bf821bed63af36cab5cdb95d25e114f5fbLa porta 8080 sulla rete locale è occupata dal container gifted_sammet (creato nella sezione precedente). Ecco perché devi utilizzare un numero di porta diverso, come 8888. Ora fai una verifica con il comando container ls:

docker container ls

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# b1db06e400c4 fhsinchy/hello-dock "/docker-entrypoint.…" 28 seconds ago Up 26 seconds 0.0.0.0:8888->80/tcp hello-dock-container

# 9f21cb777058 fhsinchy/hello-dock "/docker-entrypoint.…" 4 minutes ago Up 4 minutes 0.0.0.0:8080->80/tcp gifted_sammetÈ stato avviato un nuovo container con il nome hello-dock-container.

Puoi rinominare vecchi container usando il comando container rename. La sintassi per questo comando è la seguente:

docker container rename <identificatore container> <nuovo nome>Per rinominare il container gifted_sammet in hello-dock-container-2, esegui il seguente comando:

docker container rename gifted_sammet hello-dock-container-2Il comando non dà nessun output ma puoi verificare che i cambiamenti hanno avuto luogo usando il comando container ls. Il comando rename funziona sia per i container in esecuzione che per quelli stoppati.

Come fermare un container in esecuzione

I container in esecuzione in primo piano possono essere bloccati semplicemente chiudendo la finestra del terminale o premendo ctrl + c. I container in esecuzione in background, tuttavia, non possono essere stoppati nello stesso modo.

Ci sono due comandi relativi a questa azione. Il primo è container stop, la cui sintassi generica è riportata di seguito:

docker container stop <identificatore container>Dove identificatore container può essere sia l'id che il nome del container.

Spero ti ricordi del container che hai avviato nella sezione precedente. È ancora in esecuzione in background. Ottieni l'identificatore del container usando docker container ls (utilizzerò il container hello-dock-container per questa demo). Ora esegui il seguente comando per fermare l'esecuzione del container:

docker container stop hello-dock-container

# hello-dock-containerSe usi il nome come identificatore, otterrai il nome come output. Il comando stop ferma l'esecuzione di un container con grazia inviando un segnale SIGTERM. Se il container non si ferma entro un certo periodo, viene inviato un segnale SIGKILL che blocca immediatamente il container.

Nei casi in cui vuoi inviare un segnale SIGKILL invece di un segnale SIGTERM, puoi usare il comando container kill, che segue la stessa sintassi del comando stop.

docker container kill hello-dock-container-2

# hello-dock-container-2Come riavviare un container

Parlando di riavviare, intendo specificamente due scenari:

- Riavviare un container che è stato precedentemente stoppato.

- Riavviare un container in esecuzione.

Come hai già imparato da una sezione precedente, i container stoppati restano nel tuo sistema. Se vuoi puoi riavviarli. Il comando container start può essere usato per avviare qualsiasi container stoppato o "ucciso". La sintassi è la seguente:

docker container start <identificatore container>Puoi ottenere la lista di tutti i container eseguendo il comando container ls --all. Poi guarda i contained con lo status Exited.

docker container ls --all

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# b1db06e400c4 fhsinchy/hello-dock "/docker-entrypoint.…" 3 minutes ago Exited (0) 47 seconds ago hello-dock-container

# 9f21cb777058 fhsinchy/hello-dock "/docker-entrypoint.…" 7 minutes ago Exited (137) 17 seconds ago hello-dock-container-2

# 6cf52771dde1 fhsinchy/hello-dock "/docker-entrypoint.…" 7 minutes ago Exited (0) 7 minutes ago reverent_torvalds

# 128ec8ceab71 hello-world "/hello" 9 minutes ago Exited (0) 9 minutes ago exciting_chebyshevOra per riavviare il container hello-dock-container, puoi eseguire il seguente comando:

docker container start hello-dock-container

# hello-dock-containerPuoi assicurarti che il contenitore sia in esecuzione guardando la lista dei container in esecuzione usando il comando container ls.

Il comando container start avvia qualsiasi container in modalità detached di default e mantiene ogni configurazione di porte fatta in precedenza. Quindi se visiti http://127.0.0.1:8080, dovresti essere in grado di accedere all'applicazione hello-dock proprio come prima.

In una situazione in cui desideri riavviare un container in esecuzione puoi usare il comando container restart, che segue la stessa sintassi del comando container start.

docker container restart hello-dock-container-2

# hello-dock-container-2La differenza principale tra i due comandi è che il comando container restart tenta di fermare il container selezionato e poi lo riavvia, mentre il comando start riavvia un container già bloccato.

Nel caso di un container stoppato, entrambi i comandi vanno bene. Ma se il container è in esecuzione devi usare il comando container restart.

Come creare un container senza eseguirlo

In questa sezione, finora, hai avviato container usando il comando container run, che in realtà è la combinazione di due comandi separati:

container createcrea un container da un'immagine.container startavvia un container che è stato già creato.

Per svolgere la dimostrazione mostrata in precedenza usando questi due comandi, puoi fare qualcosa del genere:

docker container create --publish 8080:80 fhsinchy/hello-dock

# 2e7ef5098bab92f4536eb9a372d9b99ed852a9a816c341127399f51a6d053856

docker container ls --all

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# 2e7ef5098bab fhsinchy/hello-dock "/docker-entrypoint.…" 30 seconds ago Created hello-dockCome si evince dall'output del comando container ls --all, è stato creato un container con il nome hello-dock usando l'immagine fhsinchy/hello-dock. Al momento lo STATUS del container è Created e, dato che non è in esecuzione, non verrà messo in elenco senza usare l'opzione --all.

Una volta che il container è stato creato, può essere avviato usando il comando container start.

docker container start hello-dock

# hello-dock

docker container ls

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# 2e7ef5098bab fhsinchy/hello-dock "/docker-entrypoint.…" About a minute ago Up 29 seconds 0.0.0.0:8080->80/tcp hello-dockLo STATUS del container è cambiato da Created a Up 29 seconds, che indica che il container è in esecuzione. La configurazione delle porte viene mostrata nella colonna PORTS che era precedentemente vuota.

Sebbene tu possa farla franca con il comando container run nella maggior parte delle situazioni, più avanti nel manuale ci saranno alcuni casi che richiedono di usare il comando container create.

Come rimuovere dei container sospesi

Come hai già visto, i container che hai stoppato o terminato restano nel sistema. Questi container sospesi possono occupare spazio o entrare in conflitto con dei nuovi container.

Per rimuovere un container stoppato puoi usare il comando container rm, con la seguente sintassi:

docker container rm <identificatore container>Per trovare quali container non sono in esecuzione, usa il comando container ls --all e cerca i container con lo status Exited.

docker container ls --all

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# b1db06e400c4 fhsinchy/hello-dock "/docker-entrypoint.…" 6 minutes ago Up About a minute 0.0.0.0:8888->80/tcp hello-dock-container

# 9f21cb777058 fhsinchy/hello-dock "/docker-entrypoint.…" 10 minutes ago Up About a minute 0.0.0.0:8080->80/tcp hello-dock-container-2

# 6cf52771dde1 fhsinchy/hello-dock "/docker-entrypoint.…" 10 minutes ago Exited (0) 10 minutes ago reverent_torvalds

# 128ec8ceab71 hello-world "/hello" 12 minutes ago Exited (0) 12 minutes ago exciting_chebyshevCome puoi vedere nell'output, i container con gli ID 6cf52771dde1 e 128ec8ceab71 non sono in esecuzione. Per rimuovere il container 6cf52771dde1 esegui il seguente comando:

docker container rm 6cf52771dde1

# 6cf52771dde1Puoi controllare se il container è stato cancellato oppure no usando il comando container ls. Puoi anche rimuovere più container in un colpo solo passando i loro identificatori uno dopo l'altro separati da spazi.

Oppure, invece di rimuovere singoli container, se vuoi rimuovere tutti i container sospesi insieme, puoi usare il comando container prune.

Puoi controllare la lista dei container con il comando container ls --all per assicurarti che i container sospesi siano stati rimossi:

docker container ls --all

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# b1db06e400c4 fhsinchy/hello-dock "/docker-entrypoint.…" 8 minutes ago Up 3 minutes 0.0.0.0:8888->80/tcp hello-dock-container

# 9f21cb777058 fhsinchy/hello-dock "/docker-entrypoint.…" 12 minutes ago Up 3 minutes 0.0.0.0:8080->80/tcp hello-dock-container-2Se finora hai seguito il libro esattamente, dovresti vedere in elenco soltanto hello-dock-container e hello-dock-container-2. Consiglio di fermare e rimuovere entrambi i container prima di proseguire con la prossima sezione.

Esiste anche l'opzione --rm per i comandi container run e container start, che indica che vuoi che i container siano rimossi non appena vengono stoppati. Per avviare un altro container hello-dock con l'opzione --rm, esegui il seguente comando:

docker container run --rm --detach --publish 8888:80 --name hello-dock-volatile fhsinchy/hello-dock

# 0d74e14091dc6262732bee226d95702c21894678efb4043663f7911c53fb79f3Puoi usare il comando container ls per verificare che il container è in esecuzione:

docker container ls

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# 0d74e14091dc fhsinchy/hello-dock "/docker-entrypoint.…" About a minute ago Up About a minute 0.0.0.0:8888->80/tcp hello-dock-volatileSe blocchi il container e poi verifichi di nuovo con il comando container ls --all:

docker container stop hello-dock-volatile

# hello-dock-volatile

docker container ls --all

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMESIl container è stato rimosso automaticamente. D'ora in poi, userò l'opzione --rm per la maggior parte dei container. Menzionerò esplicitamente qualora non dovesse essere necessaria.

Come eseguire un container in modalità interattiva

Finora abbiamo eseguito solo container creati dalle immagini hello-world fhsinchy/hello-dock. Queste immagini sono realizzate per eseguire semplici programmi che non sono interattivi.

Beh, non tutte le immagini sono così semplici. Le immagini possono incapsulare un'intera distribuzione Linux al loro interno.

Distribuzioni popolari come Ubuntu, Fedora e Debian hanno tutte delle immagini Docker ufficiali disponibili nell'hub. Linguaggi di programmazione come python, php, go oppure runtime come node e deno hanno tutti delle immagini ufficiali.

Queste immagini non solo permettono di eseguire programmi pre-configurati. Sono anche configurate per eseguire una shell di default. Nel caso di immagini di sistemi operativi, può trattarsi di sh o bash e per linguaggi di programmazione o run-time, solitamente è il loro linguaggio shell predefinito.

Come puoi già sapere dalle tue esperienze con i computer, le shell sono programmi interattivi. Un'immagine configurata per eseguire un programma è un'immagine interattiva. Queste immagini richiedono un'opzione speciale -it da passare al comando container run.

Ad esempio, se esegui un container usando l'immagine di ubuntu eseguendo docker container run ubuntu, vedrai che non accade nulla. Ma se esegui lo stesso comando con l'opzione -it, dovresti arrivare direttamente sul bash all'interno del container di Ubuntu.

docker container run --rm -it ubuntu

# root@dbb1f56b9563:/# cat /etc/os-release

# NAME="Ubuntu"

# VERSION="20.04.1 LTS (Focal Fossa)"

# ID=ubuntu

# ID_LIKE=debian

# PRETTY_NAME="Ubuntu 20.04.1 LTS"

# VERSION_ID="20.04"

# HOME_URL="https://www.ubuntu.com/"

# SUPPORT_URL="https://help.ubuntu.com/"

# BUG_REPORT_URL="https://bugs.launchpad.net/ubuntu/"

# PRIVACY_POLICY_URL="https://www.ubuntu.com/legal/terms-and-policies/privacy-policy"

# VERSION_CODENAME=focal

# UBUNTU_CODENAME=focalCome puoi vedere dall'output del comando cat /etc/os-release, sto effettivamente interagendo con il bash in esecuzione nel container di Ubuntu.

L'opzione -it prepara il terreno in modo che tu possa interagire con qualsiasi programma interattivo all'interno di un container. Questa opzione, in realtà, è composta da due opzioni fuse insieme.

- L'opzione

-io--interactiveti connette al flusso di input del container, in modo da poter inviare input al bash. - L'opzione

-to--ttyfa sì che tu ottenga una buona formattazione e l'esperienza del terminale nativo allocando uno pseudo-terminale.

Devi usare l'opzione -it ogni volta che vuoi eseguire un container in modalità interattiva. Un altro esempio può essere l'esecuzione dell'immagine di node come segue:

docker container run -it node

# Welcome to Node.js v15.0.0.

# Type ".help" for more information.

# > ['farhan', 'hasin', 'chowdhury'].map(name => name.toUpperCase())

# [ 'FARHAN', 'HASIN', 'CHOWDHURY' ]Qualsiasi codice JavaScript valido può essere eseguito nella shell di node. Invece di scrivere -it puoi essere più verboso e scrivere separatamente --interactive --tty.

Come eseguire comandi all'interno di un container

Nella sezione Hello World in Docker di questo manuale, mi hai visto eseguire un comando all'interno di un container di Alpine Linux. È andata più o meno così:

docker run alpine uname -a

# Linux f08dbbe9199b 5.8.0-22-generic #23-Ubuntu SMP Fri Oct 9 00:34:40 UTC 2020 x86_64 LinuxHo eseguito il comando uname -a all'interno di un container di Alpine Linux. Casi come questo (dove tutto ciò che desideri è eseguire un certo comando all'interno di un container) sono piuttosto comuni.

Immagina di voler codificare una stringa usando il programma base64, disponibile su quasi ogni sistema operativo Linux o Unix (ma non su Windows).

In questa situazione, puoi avviare un container usando immagini come busybox e fargli fare il lavoro.

La sintassi generica per codificare una stringa usando base64 è la seguente:

echo -n my-secret | base64

# bXktc2VjcmV0E la sintassi generica per passare un comando a un container che non è in esecuzione è la seguente:

docker container run <nome immagine> <comando>Per svolgere la codifica base64 usando l'immagine, puoi eseguire il seguente comando:

docker container run --rm busybox sh -c "echo -n my-secret | base64

# bXktc2VjcmV0In un comando container run, qualsiasi cosa passi dopo il nome dell'immagine viene passata all'entry-point predefinito dell'immagine.

Un entry-point è come un gateway all'immagine. La maggior parte dell'immagini, eccetto le immagini eseguibili (spiegate nella sezione Come lavorare con immagini eseguibili), usano la shell o sh come entry-point predefinito. Quindi ogni comando shell valido può essere passato come argomento.

Come lavorare con immagini eseguibili

Nella sezione precedente, ho menzionato brevemente le immagini eseguibili. Queste immagini sono progettate per comportarsi come programmi eseguibili.

Prendi come esempio il mio progetto rmbyext. Si tratta di un semplice script Python in grado di cancellare file di una data estensione in modo ricorsivo. Per saperne di più, dai un'occhiata al repository:

Se hai sia Git che Python installati, puoi installare questo script eseguendo il seguente comando:

pip install git+https://github.com/fhsinchy/rmbyext.git#egg=rmbyextAssumendo che Python sia configurato correttamente nel tuo sistema, lo script dovrebbe essere disponibile ovunque tramite il terminale. La sintassi generica per questo script è la seguente:

rmbyext <estensione file>Per fare una prova, apri il terminale all'interno di una cartella vuota e crea dei file con diverse estensioni. Per farlo puoi usare il comando touch. Ora ho una cartella sul mio computer con i seguenti file:

touch a.pdf b.pdf c.txt d.pdf e.txt

ls

# a.pdf b.pdf c.txt d.pdf e.txtPer cancellare tutti i file pdf da questa cartella, puoi eseguire il seguente comando:

rmbyext pdf

# Removing: PDF

# b.pdf

# a.pdf

# d.pdfUn'immagine eseguibile per questo programma dovrebbe essere in grado di prendere le estensioni dei file come argomenti e cancellarli proprio come ha fatto il programma rmbyext.

L'immagine fhsinchy/rmbyext si comporta in modo simile. Questa immagine contiene una copia dello script rmbyext ed è configurata per eseguire lo script in una cartella /zone all'interno del container.

Ora il problema è che i container sono isolati dal sistema locale, quindi il programma rmbyext in esecuzione all'interno del container non ha accesso al file system locale. Se in qualche modo potessi creare una corrispondenza tra la cartella locale contenente i file pdf e la cartella /zone all'interno del container, i file sarebbero accessibili al container.

Un modo per garantire a un container l'accesso diretto al file system locale è usare un bind mount.

Un bind mount ti consente di formare un collegamento a due vie tra il contenuto di un file system della cartella locale (sorgente) e un'altra cartella all'interno di un container (destinazione). In questo modo, ogni modifica effettuata nella cartella di destinazione avrà effetto sulla cartella sorgente e viceversa.

Vediamo un bind mount in azione. Per eliminare i file usando questa immagine, invece del programma stesso, puoi eseguire il seguente comando:

docker container run --rm -v $(pwd):/zone fhsinchy/rmbyext pdf

# Removing: PDF

# b.pdf

# a.pdf

# d.pdfCome potresti aver già indovinato vedendo la parte -v $(pwd):/zone del comando, l'opzione -v o --volume viene usata per creare un bind mount per un container. Questa opzione accetta tre campi separati da due punti (:). La sintassi generica per l'opzione è:

--volume <percorso assoluto cartella file system locale>:<percorso assoluto cartella file system container>:<accesso read write>Il terzo campo è opzionale ma occorre passare il percorso assoluto della directory locale e quello della directory nel container.

La cartella sorgente nel mio caso è /home/fhsinchy/the-zone. Dato che il mio terminale è aperto nella cartella, $(pwd) sarà sostituito con /home/fhsinchy/the-zone, che contiene i file .pdf e .txt precedentemente menzionati.

Se vuoi saperne di più sulla sostituzione dei comandi puoi consultare questa risorsa (in inglese).

L'opzione --volume o -v è valida per container run così come per il comando container create. Esploreremo i volumi in maggiore dettaglio nelle prossime sezioni, quindi non ti preoccupare se non li comprendi ancora bene qui.

La differenza tra un'immagine normale e una eseguibile è che l'entry-point di un'immagine eseguibile è impostato su un programma personalizzato invece di sh, in questo caso il programma rmbyext. E come hai imparato nelle sezioni precedenti, tutto ciò che scrivi dopo il nome dell'immagine in un comando container run viene passato all'entry-point dell'immagine.

Quindi, alla fine, il comando docker container run --rm -v $(pwd):/zone fhsinchy/rmbyext pdf si traduce in rmbyext pdf all'interno del container. Le immagini eseguibili non sono così comuni ma possono essere utili in certi casi.

Manipolazione base delle immagini Docker

Ora che hai una buona comprensione di come eseguire dei container usando immagini disponibili pubblicamente, è tempo di imparare come creare le tue immagini.

In questa sezione, imparerai i fondamenti di come creare immagini, usarle per eseguire container e condividerle online.

Consiglio di installare Visual Studio Code con l'estensione Docker ufficiale dal marketplace. È un grande aiuto per l'esperienza di sviluppo.

Come creare un'immagine Docker

Come ho già spiegato nella sezione Hello World in Docker, le immagini sono dei file indipendenti a più livelli che agiscono come modello per creare i container Docker. Sono come una copia congelata, di sola lettura di un container.

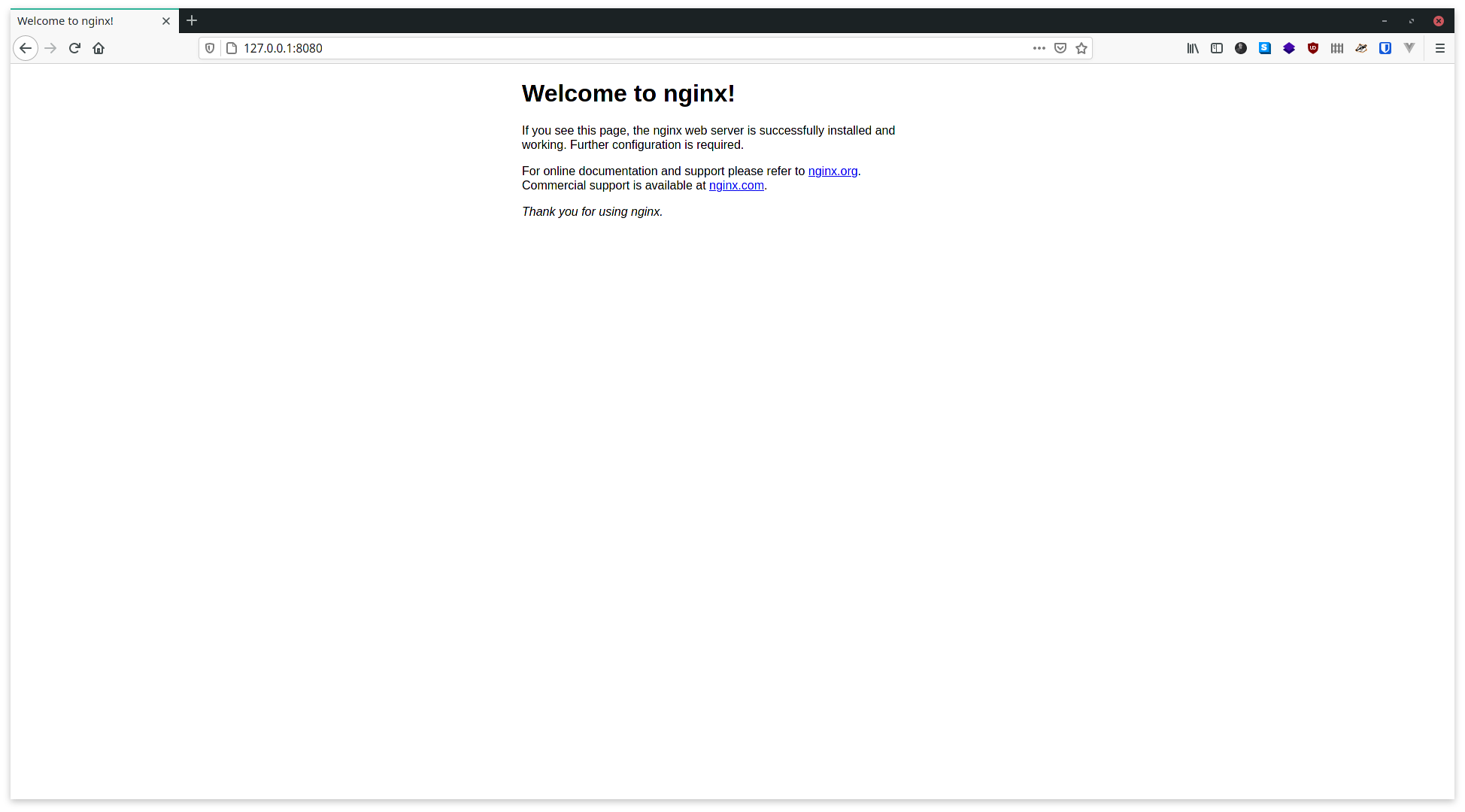

Per creare un'immagine usando uno dei tuoi programmi, devi avere una chiara visione di cosa vuoi dall'immagine. Prendi l'immagine ufficiale di nginx come esempio. Puoi avviare un container usando questa immagine eseguendo il seguente comando:

docker container run --rm --detach --name default-nginx --publish 8080:80 nginx

# b379ecd5b6b9ae27c144e4fa12bdc5d0635543666f75c14039eea8d5f38e3f56

docker container ls

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

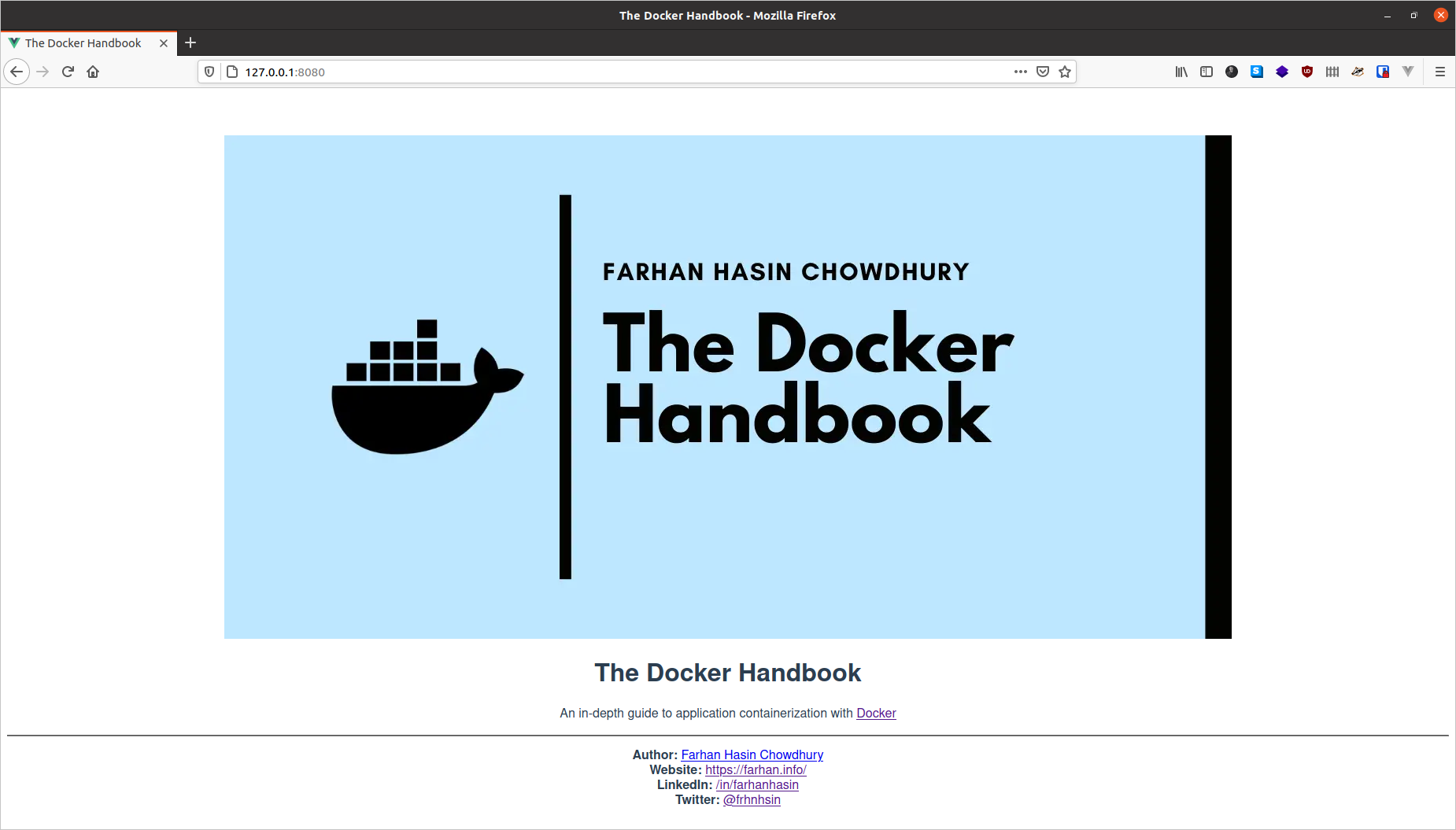

# b379ecd5b6b9 nginx "/docker-entrypoint.…" 8 seconds ago Up 8 seconds 0.0.0.0:8080->80/tcp default-nginxSe vai su http://127.0.0.1:8080 nel browser, vedrai una pagina di risposta predefinita.

Tutto perfetto, ma se volessimo realizzare un'immagine personalizzata di NGINX che funzioni esattamente come quella ufficiale? Onestamente, è una situazione assolutamente plausibile. Quindi facciamolo.

Per creare un'immagine NGINX personalizzata, devi avere un'idea chiara dello stato finale dell'immagine. Secondo me, l'immagine dovrebbe essere come segue:

- L'immagine dovrebbe avere NGINX preinstallato, il che può essere fatto usando un gestore di pacchetti o può essere generato dalla sorgente.

- L'immagine dovrebbe avviare automaticamente NGINX quando in esecuzione.

Tutto semplice. Se hai clonato il repository del progetto linkato in questo libro, vai all'interno della radice del progetto e cerca una cartella chiamata custom-nginx.

Ora crea un nuovo file chiamato Dockerfile all'interno di quella cartella. Dockerfile è un insieme di istruzioni che, una volta processate dal demone, danno come risultato un'immagine. Il contenuto di Dockerfile è il seguente:

FROM ubuntu:latest

EXPOSE 80

RUN apt-get update && \

apt-get install nginx -y && \

apt-get clean && rm -rf /var/lib/apt/lists/*

CMD ["nginx", "-g", "daemon off;"]Le immagini sono file a più livelli e in questo file, ogni riga (detta istruzione) che scrivi crea un livello dell'immagine.

- Ogni

Dockerfilevalido inizia con l'istruzioneFROM. Questa istruzione imposta la base dell'immagine risultante. Impostandoubuntu:latestcome immagine base, ottieni tutte le qualità di Ubuntu già disponibili nella tua immagine personalizzata, così da poter usare cose come il comandoapt-getper installare facilmente i pacchetti. - L'istruzione

EXPOSEè usata per indicare la porta che deve essere pubblicata. Usare questa istruzione non vuol dire che non c'è bisogno di usare esplicitamente l'opzione--publish. L'istruzioneEXPOSEfunziona esattamente come una documentazione per qualcuno che sta cercando di eseguire un container usando la tua immagine. Ha anche altri utilizzi che non discuterò qui. - L'istruzione

RUNin unDockerfileesegue un comando all'interno della shell. Il comandoapt-get update && apt-get install nginx -ycontrolla le versioni aggiornate del pacchetto e installa NGINX. Il comandoapt-get clean && rm -rf /var/lib/apt/lists/*è usato per pulire la cache del pacchetto, per non avere fardelli inutili nell'immagine. Questi due sono semplici comandi di Ubuntu, nulla di complesso. Le istruzioniRUNqui sono scritte in formashell. Possono anche essere scritte in formaexec. Per saperne di più, puoi consultare i riferimenti ufficiali. - Infine, l'istruzione

CMDdefinisce il comando di default per l'immagine. Questa istruzione è scritta in formaexec, costituita da tre parti separate.nginxsi riferisce all'eseguibile NGINX.-gedaemon offsono opzioni per NGINX. Eseguire NGINX come singolo processo all'interno del container è considerata una buona pratica, da cui l'utilizzo di questa opzione. L'istruzioneCMDPuò ancora essere scritta in formashell. Per saperne di più, puoi consultare i riferimenti ufficiali.

Ora che hai un Dockerfile valido, da questo puoi costruire un'immagine. Proprio come i comandi relativi ai container, i comandi per le immagini possono essere lanciati usando la seguente sintassi:

docker image <comando> <opzioni>Per costruire un'immagine usando il Dockerfile che hai scritto, apri il terminale all'interno della cartella custom-nginx ed esegui il seguente comando:

docker image build .

# Sending build context to Docker daemon 3.584kB

# Step 1/4 : FROM ubuntu:latest

# ---> d70eaf7277ea

# Step 2/4 : EXPOSE 80

# ---> Running in 9eae86582ec7

# Removing intermediate container 9eae86582ec7

# ---> 8235bd799a56

# Step 3/4 : RUN apt-get update && apt-get install nginx -y && apt-get clean && rm -rf /var/lib/apt/lists/*

# ---> Running in a44725cbb3fa

### LONG INSTALLATION STUFF GOES HERE ###

# Removing intermediate container a44725cbb3fa

# ---> 3066bd20292d

# Step 4/4 : CMD ["nginx", "-g", "daemon off;"]

# ---> Running in 4792e4691660

# Removing intermediate container 4792e4691660

# ---> 3199372aa3fc

# Successfully built 3199372aa3fcPer eseguire il build di un'immagine, il demone ha bisogno di due informazioni molto specifiche, ovvero il nome del Dockerfile e il contesto di build. Nel comando precedente:

docker image buildè il comando per eseguire il build dell'immagine. Il demone trova qualsiasi file chiamatoDockerfileall'interno del contesto.- Il

.alla fine definisce il contesto per questo build. Il contesto corrisponde alla cartella accessibile al demone durante il processo di build.

Adesso, per eseguire un container usando questa immagine, puoi usare il comando container run abbinato con l'ID dell'immagine che hai ottenuto come risultato del processo di build. Nel mio caso, l'id è 3199372aa3fc, visibile nella riga Successfully built 3199372aa3fc del precedente blocco di codice.

docker container run --rm --detach --name custom-nginx-packaged --publish 8080:80 3199372aa3fc

# ec09d4e1f70c903c3b954c8d7958421cdd1ae3d079b57f929e44131fbf8069a0

docker container ls

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# ec09d4e1f70c 3199372aa3fc "nginx -g 'daemon of…" 23 seconds ago Up 22 seconds 0.0.0.0:8080->80/tcp custom-nginx-packagedPer controllare, visita http://127.0.0.1:8080, dove dovresti vedere la pagina di risposta predefinita.

Come taggare le immagini Docker

Proprio come per i container, puoi assegnare identificatori personalizzati alle tue immagini invece di fare affidamento sugli ID generati casualmente. Nel caso di un'immagine, l'identificatore viene detto tag. L'opzione --tag o -t viene usata in tali casi.

La sintassi generica per questa opzione è la seguente:

--tag <repository immagine>:<tag immagine>Il repository è solitamente conosciuto come il nome dell'immagine e il tag indica un certo build o versione.

Prendi l'immagine ufficiale di mysql come esempio. Se vuoi eseguire un container usando una specifica versione di MySQL, come la 5.7, puoi eseguire docker container run mysql:5.7 dove mysql è il repository dell'immagine e 5.7 è il tag.

Per taggare l'immagine personalizzata NGINX con custom-nginx:packaged puoi eseguire il seguente comando:

docker image build --tag custom-nginx:packaged .

# Sending build context to Docker daemon 1.055MB

# Step 1/4 : FROM ubuntu:latest

# ---> f63181f19b2f

# Step 2/4 : EXPOSE 80

# ---> Running in 53ab370b9efc

# Removing intermediate container 53ab370b9efc

# ---> 6d6460a74447

# Step 3/4 : RUN apt-get update && apt-get install nginx -y && apt-get clean && rm -rf /var/lib/apt/lists/*

# ---> Running in b4951b6b48bb

### LONG INSTALLATION STUFF GOES HERE ###

# Removing intermediate container b4951b6b48bb

# ---> fdc6cdd8925a

# Step 4/4 : CMD ["nginx", "-g", "daemon off;"]

# ---> Running in 3bdbd2af4f0e

# Removing intermediate container 3bdbd2af4f0e

# ---> f8837621b99d

# Successfully built f8837621b99d

# Successfully tagged custom-nginx:packagedNulla cambierà eccetto il fatto che adesso puoi fare riferimento all'immagine con custom-nginx:packaged invece di una lunga stringa casuale.

Nei casi in cui ti dimentichi di taggare un'immagine durante il tempo di build, o magari vuoi cambiare il tag, puoi usare il comando image tag per farlo:

docker image tag <id immagine> <repository immagine>:<tag immagine>

## oppure ##

docker image tag <repository immagine>:<tag immagine> <nuovo repository immagine>:<nuovo tag immagine>Come elencare e rimuovere immagini Docker

Proprio come il comando container ls, puoi usare il comando image ls per elencare tutte le immagini nel tuo sistema locale:

docker image ls

# REPOSITORY TAG IMAGE ID CREATED SIZE

# <none> <none> 3199372aa3fc 7 seconds ago 132MB

# custom-nginx packaged f8837621b99d 4 minutes ago 132MBLe immagini elencate qui possono essere cancellate usando il comando image rm, la cui sintassi generica è:

docker image rm <identificatore immagine>L'identificatore può essere l'ID dell'immagine o il repository dell'immagine. Se usi il repository, devi specificare anche il tag. Per cancellare l'immagine personalizzata custom-nginx:packaged, puoi eseguire il seguente comando:

docker image rm custom-nginx:packaged

# Untagged: custom-nginx:packaged

# Deleted: sha256:f8837621b99d3388a9e78d9ce49fbb773017f770eea80470fb85e0052beae242

# Deleted: sha256:fdc6cdd8925ac25b9e0ed1c8539f96ad89ba1b21793d061e2349b62dd517dadf

# Deleted: sha256:c20e4aa46615fe512a4133089a5cd66f9b7da76366c96548790d5bf865bd49c4

# Deleted: sha256:6d6460a744475a357a2b631a4098aa1862d04510f3625feb316358536fcd8641Puoi anche usare il comando image prune per fare pulizia di tutte le immagini sospese non taggate, come segue:

docker image prune --force

# Deleted Images:

# deleted: sha256:ba9558bdf2beda81b9acc652ce4931a85f0fc7f69dbc91b4efc4561ef7378aff

# deleted: sha256:ad9cc3ff27f0d192f8fa5fadebf813537e02e6ad472f6536847c4de183c02c81

# deleted: sha256:f1e9b82068d43c1bb04ff3e4f0085b9f8903a12b27196df7f1145aa9296c85e7

# deleted: sha256:ec16024aa036172544908ec4e5f842627d04ef99ee9b8d9aaa26b9c2a4b52baa

# Total reclaimed space: 59.19MBL'opzione --force o -f salta ogni domanda di conferma. Puoi anche usare l'opzione --all o -a per rimuovere tutte le immagini nella cache del tuo registro locale.

Come comprendere i livelli di un'immagine Docker

Fin dall'inizio di questo libro, ho detto che le immagini sono file a più livelli. In questa sezione, mostrerò i vari livelli di un'immagine e come giocano un ruolo importante nel processo di build dell'immagine.

Per questa dimostrazione, utilizzerò l'immagine custom-nginx:packaged della sezione precedente.

Per visualizzare i molti livelli di un'immagine, puoi usare il comando image history. I vari livelli dell'immagine custom-nginx:packaged possono essere visualizzati come segue:

docker image history custom-nginx:packaged

# IMAGE CREATED CREATED BY SIZE COMMENT

# 7f16387f7307 5 minutes ago /bin/sh -c #(nop) CMD ["nginx" "-g" "daemon… 0B

# 587c805fe8df 5 minutes ago /bin/sh -c apt-get update && apt-get ins… 60MB

# 6fe4e51e35c1 6 minutes ago /bin/sh -c #(nop) EXPOSE 80 0B

# d70eaf7277ea 17 hours ago /bin/sh -c #(nop) CMD ["/bin/bash"] 0B

# <missing> 17 hours ago /bin/sh -c mkdir -p /run/systemd && echo 'do… 7B

# <missing> 17 hours ago /bin/sh -c [ -z "$(apt-get indextargets)" ] 0B

# <missing> 17 hours ago /bin/sh -c set -xe && echo '#!/bin/sh' > /… 811B

# <missing> 17 hours ago /bin/sh -c #(nop) ADD file:435d9776fdd3a1834… 72.9MBCi sono otto livelli in questa immagine. Quello superiore è l'ultimo e man mano che scendi diventano meno recenti. Il livello superiore è quello che di solito si usa per eseguire i container.

Ora, diamo un'occhiata da vicino alle immagini partendo dall'immagine d70eaf7277ea fino a 7f16387f7307. Ignorerò i quattro livelli inferiori in cui IMAGE è <missing> (mancante), che non sono una nostra preoccupazione.

d70eaf7277eaè stato creato da/bin/sh -c #(nop) CMD ["/bin/bash"]che indica che la shell predefinita all'interno di Ubuntu è stata caricata con successo.6fe4e51e35c1è stato creato da/bin/sh -c #(nop) EXPOSE 80che era la seconda istruzione nel codice.587c805fe8dfè stato creato da/bin/sh -c apt-get update && apt-get install nginx -y && apt-get clean && rm -rf /var/lib/apt/lists/*, la terza istruzione nel codice. Puoi anche vedere che questa immagine ha una dimensione di60MBvisti tutti i pacchetti che sono stati installati durante l'esecuzione di questa istruzione.- Infine, il livello più alto

7f16387f7307è stato creato da/bin/sh -c #(nop) CMD ["nginx", "-g", "daemon off;"], che definisce il comando di default per quest'immagine.

Come puoi vedere, l'immagine comprende molti livelli di sola lettura, ognuno dei quali registra un nuovo set di cambiamenti allo stato innescati da determinate istruzioni. Quando avvii un container usando un'immagine, ottieni un nuovo livello scrivibile sopra agli altri livelli.

Questo fenomeno di stratificazione che avviene ogni volta che lavori con Docker è reso possibile da un magnifico concetto tecnico detto union file system. Union si riferisce all'unione nella teoria degli insiemi. Secondo Wikipedia:

Consente di sovrapporre in modo trasparente file e directory di file system separati, detti branch (rami), per formare un singolo file system coerente. I contenuti delle directory che hanno lo stesso percorso nei rami uniti, saranno visti come se fossero nella stessa directory del file system virtuale.

Utilizzando questo concetto, Docker può evitare la duplicazione dei dati e utilizzare i livelli precedentemente creati come cache per i build successivi. Ciò dà come risultato immagini compatte ed efficienti che possono essere usate ovunque.

Come eseguire il build di NGINX dalla sorgente

Nella sezione precedente, hai imparato le istruzioni FROM, EXPOSE, RUN e CMD. In questa sezione, parleremo molto di altre istruzioni.

Creeremo ancora un'immagine NGINX personalizzata. Ma invece di usare un gestore di pacchetti come apt-get dell'esempio precedente, farai il build di NGINX dalla sorgente.

Per eseguire il build di NGINX dalla sorgente, hai bisogno del file sorgente di NGINX. Se hai clonato il mio repository, vedrai un file chiamato nginx-1.19.2.tar.gz nella cartella custom-nginx. Userai questo archivio come sorgente per fare il build di NGINX.

Prima di immergerci nel codice, pianifichiamo il processo. La creazione dell'immagine stavolta può essere fatta nei sette passaggi elencati di seguito:

- Ottenere una buona immagine di base per il build dell'applicazione, come ubuntu.

- Installare le dipendenze di build necessarie sull'immagine di base.

- Copiare il file

nginx-1.19.2.tar.gzall'interno dell'immagine. - Estrarre i contenuti dell'archivio e liberarsene.

- Configurare il build, compilare e installare il programma usando lo strumento

make. - Liberarsi del codice sorgente estratto.

- Lanciare l'eseguibile

nginx.

Ora che abbiamo un piano, inizia aprendo il vecchio Dockerfile, aggiornandone il contenuto come segue:

FROM ubuntu:latest

RUN apt-get update && \

apt-get install build-essential\

libpcre3 \

libpcre3-dev \

zlib1g \

zlib1g-dev \

libssl1.1 \

libssl-dev \

-y && \

apt-get clean && rm -rf /var/lib/apt/lists/*

COPY nginx-1.19.2.tar.gz .

RUN tar -xvf nginx-1.19.2.tar.gz && rm nginx-1.19.2.tar.gz

RUN cd nginx-1.19.2 && \

./configure \

--sbin-path=/usr/bin/nginx \

--conf-path=/etc/nginx/nginx.conf \

--error-log-path=/var/log/nginx/error.log \

--http-log-path=/var/log/nginx/access.log \

--with-pcre \

--pid-path=/var/run/nginx.pid \

--with-http_ssl_module && \

make && make install

RUN rm -rf /nginx-1.19.2

CMD ["nginx", "-g", "daemon off;"]Come puoi vedere, il codice all'interno di Dockerfile riflette i sette passaggi di cui ho parlato.

- L'istruzione

FROMdefinisce Ubuntu come immagine di base creando un ambiente ideale per il build di qualsiasi applicazione. - L'istruzione

RUNinstalla i pacchetti standard necessari per il build di NGINX dalla sorgente. - L'istruzione

COPYè qualcosa di nuovo. Questa istruzione è responsabile di copiare il filenginx-1.19.2.tar.gzall'interno dell'immagine. La sintassi generica dell'istruzioneCOPYèCOPY <sorgente> <destinazione>, dove la sorgente è nel tuo file system locale e la destinazione è all'interno dell'immagine..come destinazione si riferisce alla cartella di lavoro all'interno dell'immagine che è di default/, se non impostata diversamente. - La seconda istruzione

RUNestrae il contenuto dall'archivio usandotare in seguito se ne sbarazza. - Il file di archivio contiene una cartella chiamata

nginx-1.19.2con il codice sorgente. Quindi, nel prossimo passaggio, dovrai spostarti in questa directory (cd) e svolgere il processo di build. Se vuoi imparare di più su questo argomento puoi leggere questo articolo (risorsa in inglese). - Una volta che il build e l'installazione sono completati, rimuovi la cartella

nginx-1.19.2usando il comandorm. - Nello step finale, avvia NGINX nella modalità a processo singolo, proprio come hai fatto prima.

Per fare il build di un'immagine usando questo codice, esegui il seguente comando:

docker image build --tag custom-nginx:built .

# Step 1/7 : FROM ubuntu:latest

# ---> d70eaf7277ea

# Step 2/7 : RUN apt-get update && apt-get install build-essential libpcre3 libpcre3-dev zlib1g zlib1g-dev libssl-dev -y && apt-get clean && rm -rf /var/lib/apt/lists/*

# ---> Running in 2d0aa912ea47

### LONG INSTALLATION STUFF GOES HERE ###

# Removing intermediate container 2d0aa912ea47

# ---> cbe1ced3da11

# Step 3/7 : COPY nginx-1.19.2.tar.gz .

# ---> 7202902edf3f

# Step 4/7 : RUN tar -xvf nginx-1.19.2.tar.gz && rm nginx-1.19.2.tar.gz

---> Running in 4a4a95643020

### LONG EXTRACTION STUFF GOES HERE ###

# Removing intermediate container 4a4a95643020

# ---> f9dec072d6d6

# Step 5/7 : RUN cd nginx-1.19.2 && ./configure --sbin-path=/usr/bin/nginx --conf-path=/etc/nginx/nginx.conf --error-log-path=/var/log/nginx/error.log --http-log-path=/var/log/nginx/access.log --with-pcre --pid-path=/var/run/nginx.pid --with-http_ssl_module && make && make install

# ---> Running in b07ba12f921e

### LONG CONFIGURATION AND BUILD STUFF GOES HERE ###

# Removing intermediate container b07ba12f921e

# ---> 5a877edafd8b

# Step 6/7 : RUN rm -rf /nginx-1.19.2

# ---> Running in 947e1d9ba828

# Removing intermediate container 947e1d9ba828

# ---> a7702dc7abb7

# Step 7/7 : CMD ["nginx", "-g", "daemon off;"]

# ---> Running in 3110c7fdbd57

# Removing intermediate container 3110c7fdbd57

# ---> eae55f7369d3

# Successfully built eae55f7369d3

# Successfully tagged custom-nginx:builtQuesto codice va bene, ma ci sono dei punti in cui possiamo fare dei miglioramenti.

- Invece di scrivere il nome del file in codifica fissa come

nginx-1.19.2.tar.gz, puoi creare un argomento usando l'istruzioneARG. In questo modo, sarai in grado di cambiare la versione o il nome del file cambiando l'argomento. - Invece di scaricare manualmente l'archivio, puoi far scaricare il file al demone durante il processo di build. Esiste un'altra istruzione come

COPY, chiamataADD, che ti consente di aggiungere dei file da internet.

Apri il file Dockerfile e aggiorna il suo contenuto come segue:

FROM ubuntu:latest

RUN apt-get update && \

apt-get install build-essential\

libpcre3 \

libpcre3-dev \

zlib1g \

zlib1g-dev \

libssl1.1 \

libssl-dev \

-y && \

apt-get clean && rm -rf /var/lib/apt/lists/*

ARG FILENAME="nginx-1.19.2"

ARG EXTENSION="tar.gz"

ADD https://nginx.org/download/${FILENAME}.${EXTENSION} .

RUN tar -xvf ${FILENAME}.${EXTENSION} && rm ${FILENAME}.${EXTENSION}

RUN cd ${FILENAME} && \

./configure \

--sbin-path=/usr/bin/nginx \

--conf-path=/etc/nginx/nginx.conf \

--error-log-path=/var/log/nginx/error.log \

--http-log-path=/var/log/nginx/access.log \

--with-pcre \

--pid-path=/var/run/nginx.pid \

--with-http_ssl_module && \

make && make install

RUN rm -rf /${FILENAME}}

CMD ["nginx", "-g", "daemon off;"]Il codice è quasi identico al blocco di codice precedente, eccetto per delle nuove istruzioni ARG sulle righe 13, 14 e per l'uso dell'istruzione ADD sulla riga 16. La spiegazione per il codice aggiornato è riportata di seguito:

- L'istruzione

ARGti permette di dichiarare variabili come in altri linguaggi. Queste variabili o argomenti possono essere consultate in seguito usando la sintassi${nome argomento}. Qui ho usatonginx-1.19.2come nome del file etar.gzcome estensione in due argomenti separati. In questo modo posso passare a nuove versioni di NGINX o al formato archivio facendo una modifica in un solo posto. Nel codice qui sopra, ho aggiunto i valori predefiniti alle variabili. I valori delle variabili possono anche essere passati come opzioni del comandoimage build. Puoi consultare i riferimenti ufficiali per maggiori dettagli. - Nell'istruzione

ADD, ho formato l'URL del download dinamicamente, usando gli argomenti dichiarati in precedenza. La rigahttps://nginx.org/download/${FILENAME}.${EXTENSION}darà come risultatohttps://nginx.org/download/nginx-1.19.2.tar.gzdurante il processo di build. Puoi cambiare la versione del file e l'estensione soltanto in un punto grazie all'istruzioneARG. - L'istruzione

ADDnon estrae i file ottenuti da internet in modo predefinito, per cui l'utilizzo ditarnella riga 18.

Il resto del codice è praticamente invariato. Adesso dovresti essere in grado di capire da solo l'utilizzo degli argomenti. Infine, proviamo a fare il build dell'immagine da questo codice aggiornato.

docker image build --tag custom-nginx:built .

# Step 1/9 : FROM ubuntu:latest

# ---> d70eaf7277ea

# Step 2/9 : RUN apt-get update && apt-get install build-essential libpcre3 libpcre3-dev zlib1g zlib1g-dev libssl-dev -y && apt-get clean && rm -rf /var/lib/apt/lists/*

# ---> cbe1ced3da11

### LONG INSTALLATION STUFF GOES HERE ###

# Step 3/9 : ARG FILENAME="nginx-1.19.2"

# ---> Running in 33b62a0e9ffb

# Removing intermediate container 33b62a0e9ffb

# ---> fafc0aceb9c8

# Step 4/9 : ARG EXTENSION="tar.gz"

# ---> Running in 5c32eeb1bb11

# Removing intermediate container 5c32eeb1bb11

# ---> 36efdf6efacc

# Step 5/9 : ADD https://nginx.org/download/${FILENAME}.${EXTENSION} .

# Downloading [==================================================>] 1.049MB/1.049MB

# ---> dba252f8d609

# Step 6/9 : RUN tar -xvf ${FILENAME}.${EXTENSION} && rm ${FILENAME}.${EXTENSION}

# ---> Running in 2f5b091b2125

### LONG EXTRACTION STUFF GOES HERE ###

# Removing intermediate container 2f5b091b2125

# ---> 2c9a325d74f1

# Step 7/9 : RUN cd ${FILENAME} && ./configure --sbin-path=/usr/bin/nginx --conf-path=/etc/nginx/nginx.conf --error-log-path=/var/log/nginx/error.log --http-log-path=/var/log/nginx/access.log --with-pcre --pid-path=/var/run/nginx.pid --with-http_ssl_module && make && make install

# ---> Running in 11cc82dd5186

### LONG CONFIGURATION AND BUILD STUFF GOES HERE ###

# Removing intermediate container 11cc82dd5186

# ---> 6c122e485ec8

# Step 8/9 : RUN rm -rf /${FILENAME}}

# ---> Running in 04102366960b

# Removing intermediate container 04102366960b

# ---> 6bfa35420a73

# Step 9/9 : CMD ["nginx", "-g", "daemon off;"]

# ---> Running in 63ee44b571bb

# Removing intermediate container 63ee44b571bb

# ---> 4ce79556db1b

# Successfully built 4ce79556db1b

# Successfully tagged custom-nginx:builtOra dovresti essere in grado di eseguire un container usando l'immagine custom-nginx:built.

docker container run --rm --detach --name custom-nginx-built --publish 8080:80 custom-nginx:built

# 90ccdbc0b598dddc4199451b2f30a942249d85a8ed21da3c8d14612f17eed0aa

docker container ls

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

# 90ccdbc0b598 custom-nginx:built "nginx -g 'daemon of…" 2 minutes ago Up 2 minutes 0.0.0.0:8080->80/tcp custom-nginx-builtUn container che usa l'immagine custom-nginx:built-v2 è stato eseguito con successo. Il container dovrebbe essere accessibile all'indirizzo http://127.0.0.1:8080.

Ed ecco la pagina di risposta predefinita di NGINX. Puoi visitare il sito di riferimento ufficiale per imparare altro sulle istruzioni disponibili.

Come ottimizzare le immagini Docker

L'immagine di cui abbiamo fatto il build nell'ultima sezione è funzionale ma non ottimizzata. Per provarlo, diamo un'occhiata alla dimensione dell'immagine usando il comando image ls:

docker image ls

# REPOSITORY TAG IMAGE ID CREATED SIZE

# custom-nginx built 1f3aaf40bb54 16 minutes ago 343MBPer un'immagine contenente solo NGINX è troppo. Se scarichi l'immagine ufficiale e verifichi la sua dimensione, vedrai quanto è ridotta:

docker image pull nginx:stable

# stable: Pulling from library/nginx

# a076a628af6f: Pull complete

# 45d7b5d3927d: Pull complete

# 5e326fece82e: Pull complete

# 30c386181b68: Pull complete

# b15158e9ebbe: Pull complete

# Digest: sha256:ebd0fd56eb30543a9195280eb81af2a9a8e6143496accd6a217c14b06acd1419

# Status: Downloaded newer image for nginx:stable

# docker.io/library/nginx:stable

docker image ls

# REPOSITORY TAG IMAGE ID CREATED SIZE

# custom-nginx built 1f3aaf40bb54 25 minutes ago 343MB

# nginx stable b9e1dc12387a 11 days ago 133MBPer capirne la ragione, iniziamo dando uno sguardo a Dockerfile:

FROM ubuntu:latest

RUN apt-get update && \

apt-get install build-essential\

libpcre3 \

libpcre3-dev \

zlib1g \

zlib1g-dev \

libssl1.1 \

libssl-dev \

-y && \